Sztuczna inteligencja jako wirtualny respondent badania – rewolucja w analizie dobrostanu pracowników

Czy sztuczna inteligencja może pomóc przewidzieć, jak nowe zasady w firmie wpłyną na samopoczucie pracowników? Jak wykorzystać nowoczesne technologie, by firmy podejmowały lepsze decyzje dotyczące polityki organizacyjnej? Te pytania stają się coraz ważniejsze w erze dynamicznych zmian w środowisku pracy.

Wirtualni respondenci zamiast tradycyjnych ankiet

Badania nad dobrostanem pracowników tradycyjnie opierają się na czasochłonnych ankietach i wywiadach. Wymagają zaangażowania dużej liczby osób, a ich organizacja zajmuje tygodnie, a nawet miesiące. Co więcej, trudno przetestować wpływ polityki organizacyjnej, która jeszcze nie została wdrożona – zazwyczaj firmy najpierw wprowadzają zmiany, a dopiero potem mierzą ich efekty.

Nowatorskie badanie przeprowadzone w ramach projektu „Zarządzanie kompleksowe i adaptacyjne: Wykorzystanie wniosków z Równowagi Nasha dla Governance i tworzenia polityki z naciskiem na jakość życia" (ang. „Complex Adaptive Management: Leveraging Nash Equilibrium Insights for the QoL-oriented Governance") proponuje zupełnie inne podejście. Zamiast pytać prawdziwych pracowników, badacze wykorzystali duże modele językowe (LLM), by symulować ich odpowiedzi na kwestionariusz dobrostanu psychologicznego.

Program badawczy kierowany przez dr Katarzynę B. Wojtkiewicz stawia sobie za cel sprawdzenie, czy można stworzyć specjalny model matematyczny, który lepiej odzwierciedla sposób, w jaki ludzie podejmują ważne decyzje. Naukowcom zaangażowanym w projekt zależało na tym, by model nie skupiał się wyłącznie na analizie faktów i logicznych przesłanek, lecz uwzględniał również emocje, które w określonym stopniu wpływają na podejmowane wybory. Wyniki mogą pomóc w kierowaniu firmami i organizacjami poprzez zaproponowanie sposbu zarządzania bardziej zrównoważonego i przyjaznego ludziom – skupiającego się na poprawie jakości życia, nie tylko na zysku. Pomoże w tym wykorzystanie m.in. narzędzi sztucznej inteligencji.

Okazuje się, że spółczesne modele językowe pokroju GPT są zdolne do wydawania sądów podobnych do ludzkich w wielu obszarach. Wynika to z faktu, że modele te uczą się na ogromnych zbiorach danych tekstowych tworzonych przez ludzi, nabywając statystyczną wiedzę o tym, jak różne osoby odpowiadają na pytania.

Jak działa symulacja respondentów?

Metoda wykorzystana w badaniu składa się z kilku kluczowych etapów:

- Przygotowanie profili demograficznych: badacze stworzyli szczegółowe opisy fikcyjnych pracowników kancelarii prawnych, oparte na rzeczywistych danych demograficznych (takich jak wiek, płeć, stanowisko, doświadczenie zawodowe, stan rodzinny, miejsce zamieszkania, zarobki itd.).;

- Symulowanie odpowiedzi bazowych: dla każdego profilu model AI generował odpowiedzi na wszystkie pytania kwestionariusza Ryff (popularne narzędzie mierzące różne wymiary dobrostanu psychologicznego, takie jak autonomia, rozwój osobisty czy panowanie nad otoczeniem);

- Symulacja wpływu nowej polityki: badacze wysłali wirtualny respondentom powiadomienie o wprowadzeniu nowej polityki wspierającej budowanie marki osobistej pracowników i poprosili o ponowne odpowiedzi na ten sam kwestionariusz;

- Analiza zmian: porównano odpowiedzi „przed” i „po” wprowadzeniu polityki, by ocenić jej potencjalny wpływ na dobrostan pracowników.

Wnioski z tego projektu mogą wprowadzić istotne zmiany w sposobie, w jaki organizacje analizują i wspierają dobrostan swoich pracowników, a tym samym przyczynić się do tworzenia zdrowszego, bardziej zrównoważonego środowiska pracy. Badanie nie ma na celu całkowitego zastąpienia tradycyjnych metod, lecz ich uzupełnienie. AI może stanowić szybkie narzędzie do testowania hipotez, projektowania ankiet czy planowania zmian w firmie, aby w przyszłości tworzyć bardziej świadome i odpowiedzialne decyzje – co wpisuje się w cel strategiczny nauk o zarządzaniu i rozwoju społeczno-gospodarczego w duchu odpowiedzialnego i świadomego kształtowania środowiska pracy.

Co ciekawe, badacze nie wymyślali opinii o nowej polityce – wykorzystali rzeczywiste dane z ankiety przeprowadzonej w kancelarii prawniczej. Te opinie zostały skategoryzowane według stanowisk i włączone do symulacji, dzięki czemu model mógł uwzględnić typowe nastroje panujące w różnych grupach zawodowych.

Dodatkowym istotnym aspektem metody było wykorzystanie modeli działających w środowisku lokalnym, co stanowi ważne zabezpieczenie w kontekście poufności danych organizacyjnych. W badaniu zastosowano modele specjalnie wytrenowane do rozumienia języka polskiego (Bielik, PLLuM), co zwiększa trafność symulacji w rodzimym kontekście kulturowym i językowym. Lokalne przetwarzanie danych eliminuje ryzyko związane z przesyłaniem wrażliwych informacji do zewnętrznych serwerów, zapewniając pełną kontrolę nad procesem badawczym i zgodność z restrykcyjnymi wymogami ochrony danych osobowych.

Dlaczego to podejście jest innowacyjne?

Tradycyjne metody badawcze mają swoje ograniczenia. Jak zauważają naukowcy związani z projektem AITurk, to co zajęłoby niemal dwa tygodnie zbierania danych na platformach crowdsourcingowych i kosztowało kilka tysięcy dolarów, model ChatGPT jest w stanie wygenerować w kilkanaście minut za ułamek tych kosztów.

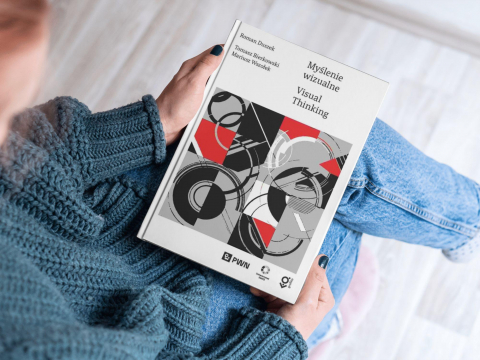

Ale oszczędność czasu i pieniędzy to niejedyna zaleta. Argyle i współpracownicy wprowadzili termin „wierność algorytmiczna” (ang. algorithmic fidelity) na opisanie zdolności modeli językowych do wiernego odtwarzania rozkładów odpowiedzi różnych grup ludzi po odpowiednim „uaktywnieniu” kontekstem demograficznym.

W praktyce oznacza to, że dobrze zaprojektowany eksperyment z modelem językowym może dostarczyć wyników podobnych do tych uzyskanych od prawdziwych ludzi – pod warunkiem, że model otrzyma odpowiedni kontekst i zostanie właściwie „nastrojony”.

Jak zapewnić wiarygodność symulacji?

W badaniu zastosowano kilka kluczowych technik zwiększających realizm symulacji:

- przekazywanie kontekstu poprzednich odpowiedzi: model „pamiętał” swoje wcześniejsze odpowiedzi, co zwiększało spójność całego kwestionariusza

- wykorzystanie rzeczywistych opinii o polityce wspierania marek osobistych: zamiast wymyślać reakcje, badacze bazowali na prawdziwych zanonimizowanych danych z ankiety

- porównanie wyników uzyskanych z różnych modeli AI: analiza zbieżności odpowiedzi potwierdziła, że różne modele generują podobne profile dla tych samych typów respondentów.

W kolejnym etapie badania planowane jest kompleksowe porównanie odpowiedzi wygenerowanych przez różne modele językowe z danymi zebranymi od prawdziwych respondentów. Badacze zamierzają przeprowadzić ankietę kontrolną w wybranych kancelariach prawnych, stosując identyczny kwestionariusz Ryff jak w symulacji AI. Szczególną uwagę poświęcą analizie rozbieżności między przewidywaniami modeli a rzeczywistymi odpowiedziami pracowników w poszczególnych grupach zawodowych i demograficznych. Badacze planują również przeprowadzić pogłębione wywiady z wybranymi pracownikami, aby lepiej zrozumieć przyczyny ewentualnych różnic między symulowanymi a rzeczywistymi odpowiedziami. Wyniki tej walidacji będą kluczowe dla oceny praktycznej użyteczności proponowanej metody w polskich organizacjach oraz dla opracowania standardów jej stosowania w badaniach organizacyjnych.

Czy modele językowe mogą zastąpić ludzi w badaniach?

Choć wyniki są obiecujące, badacze podkreślają, że symulacje nie zastępują tradycyjnych badań, lecz je uzupełniają. Nikt odpowiedzialny nie postuluje całkowitego zastąpienia ludzi przez AI w badaniach, a jedynie stosowanie AI jako uzupełnienia, podkreślają eksperci.

Modele językowe mają swoje ograniczenia. Park i współpracownicy ostrzegają, że LLM mogą wykazywać „efekt jednej poprawnej odpowiedzi” – tendencję do uśredniania opinii i zmniejszania różnorodności poglądów. Badania pokazują również, że modele przejawiają bias społecznej aprobaty – mają skłonność do odpowiedzi społecznie pożądanych.

Ponadto modele nie odczuwają emocji ani nie posiadają samoświadomości. Ich odpowiedzi opierają się na symulowanych deklaracjach, a nie autentycznym doświadczeniu dobrostanu. To rodzi pytanie, na ile model może oddać złożoność ludzkiej psychiki.

Praktyczne zastosowania tej metody

Mimo ograniczeń symulacje z wykorzystaniem AI otwierają fascynujące możliwości:

- Szybkie testowanie hipotez: badacze mogą sprawdzić, czy ich pomysły mają sens, zanim zainwestują w pełnowymiarowe badanie;

- Projektowanie lepszych kwestionariuszy: jeśli model reaguje nieoczekiwanie na pewne sformułowania pytań, może to wskazywać na potrzebę ich poprawy;

- Przewidywanie efektów planowanych zmian: organizacje mogą symulować reakcje pracowników na nowe polityki przed wdrożeniem;

- Personalizacja interwencji: wyniki symulacji mogą pomóc w tworzeniu programów wsparcia dostosowanych do różnych grup pracowników.

Wykorzystanie modelu językowego jako symulowanego respondenta stanowi obiecujące uzupełnienie klasycznych metod, mogące częściowo złagodzić trudności związane z tradycyjnym zbieraniem danych.

Co to oznacza dla przyszłości badań organizacyjnych?

Metoda opisana w badaniu może zrewolucjonizować sposób, w jaki organizacje podejmują decyzje dotyczące polityki personalnej. Zamiast wprowadzać zmiany i dopiero potem mierzyć ich efekty, firmy mogą wcześniej przetestować różne scenariusze i wybrać te, które najprawdopodobniej przyniosą najlepsze rezultaty.

Czy sztuczna inteligencja zastąpi kiedyś tradycyjne ankiety pracownicze? Raczej nie. Ale jako uzupełnienie istniejących metod, symulacje z wykorzystaniem AI mogą pomóc organizacjom podejmować lepsze, bardziej świadome decyzje dotyczące dobrostanu pracowników.

Artykuł powstał na podstawie badania zrealizowanego w ramach projektu kierowanego przez dr Katarzynę B. Wojtkiewicz pt. „Zarządzanie kompleksowe i adaptacyjne: Wykorzystanie wniosków z Równowagi Nasha dla Governance i tworzenia polityki z naciskiem na jakość życia" (ang. „Complex Adaptive Management: Leveraging Nash Equilibrium Insights for the QoL-oriented Governance") finansowanego ze środków Funduszu Rozwoju Badań Naukowych Uniwersytetu SWPS (decyzja nr 51/2024/FRBN/G).